Nel corso dell’ultimo anno ho cercato di evidenziare quanto sia importante l’archiviazione dei dati, specialmente dei dati vecchi — o freddi, come si dice in gergo tecnico — per aumentare il livello di sicurezza complessivo.

Avere meno “porte” da controllare, infatti, consente di concentrare gli sforzi sul cuore dell’infrastruttura da proteggere.

Ora provo a rendere questo processo semplice anche dal punto di vista tecnico, perché in realtà lo è davvero.

Impostare i sistemi di archiviazione dei dati non acceduti

La regola base dell’archiviazione è considerare freddi i dati non acceduti, ad esempio, da più di uno o due anni. Purtroppo, sulle versioni più recenti di Windows Server, l’opzione che consente di identificare i singoli file in base alla data di ultimo accesso è disabilitata di default: è quindi necessario riattivarla oppure adottare un criterio alternativo, come la data di ultima modifica, che consenta comunque di sfruttare al meglio il processo di archiviazione. Contestualmente è necessario attivare uno strumento di archiviazione, ad esempio una macchina virtuale che dialoghi con il file server — che ricordo può essere anche uno storage che espone servizi CIFS o NFS — e che raccolga le informazioni sui file, determinando in modo concreto quanto materiale sia effettivamente archiviabile.

Opzioni di Storage dati e Archiviazione NAS

La prima fase di un progetto di archiviazione è quella di monitoring, fase che rimane estremamente importante.

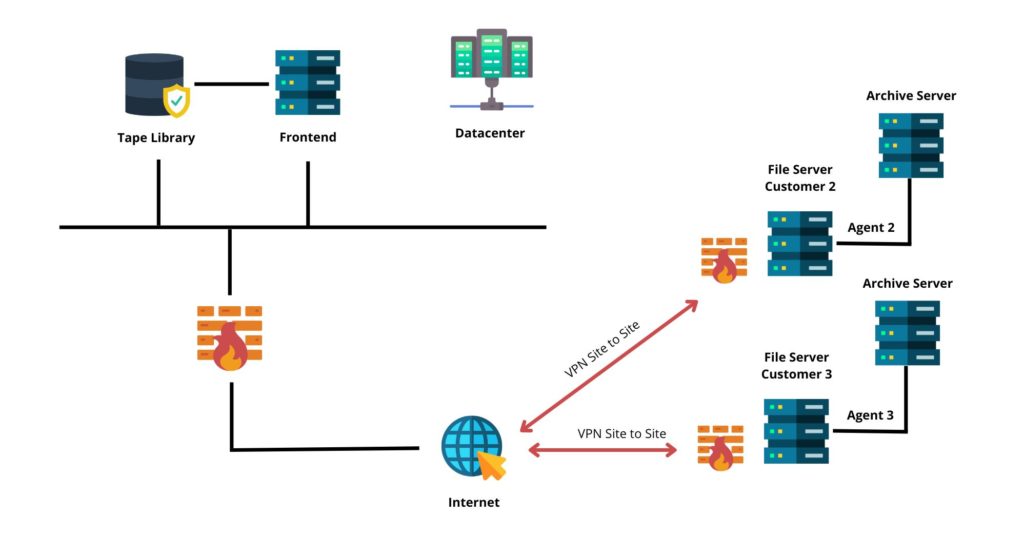

In parallelo deve essere definita la destinazione dei file archiviabili, comunemente chiamata Archive Tier. La scelta migliore, in termini di rapporto prezzo/prestazioni, è una libreria a nastro esposta come storage S3. Da sola però, questa non è sufficiente, soprattutto in presenza di grandi volumi di dati.

Qui diventa necessario affiancare un ulteriore livello di archiviazione, il Capacity Tier, ad esempio un sistema di archiviazione NAS con funzionalità S3. Questo funge da cache e da front-end di servizio, così che sia la scrittura sia la lettura dei dati archiviati non dipendano direttamente dal nastro.

Va inoltre considerato che la libreria deve disporre di un numero minimo di teste (i cosiddetti drive), variabile in base alla quantità di dati da archiviare e al numero di utenti che accedono contemporaneamente al sistema, sia in lettura sia in scrittura.

Quando si avviano questi processi, non è raro riuscire ad archiviare dal 70 al 90% dei file: lo spostamento iniziale dei dati è quindi massivo e significativo.

Il miglior sistema di archiviazione dati

Una volta predisposto l’ambiente, si può avviare il processo e passare alla fase di archiviazione vera e propria. Il suggerimento è di procedere per gradi, partendo da specifici rami del file server.

Un sistema di archiviazione efficace deve mantenere i diritti di accesso sui file: in caso contrario, tutti potrebbero vedere tutto oppure, peggio ancora, l’accesso all’archivio richiederebbe ogni volta l’intervento dell’amministratore di rete.

Scegliere un sistema di archiviazione digitale

Il processo può essere riassunto nei seguenti punti:

- Analisi dei dati sorgenti

- Spostamento del dato dal source al destination con contestuale generazione di file di stub (alias o puntatori) e quindi scrittura del dato nel “Capacity Tier”

- Spostamento graduale del dato dal “Capacity Tier” verso “Archive Tier”, magari in doppia copia su due nastri distinti per avere maggior sicurezza

- Utilizzo del servizio in produzione

Il suggerimento finale è quello di acquistare un servizio piuttosto che l’intera infrastruttura.

Se lasciamo i nostri soldi in banca fidandoci di un istituto di credito, possiamo anche affidarci a organizzazioni che garantiscono riservatezza e sicurezza per i nostri dati freddi e storici.

Con MEET IT forniamo un servizio di archiviazione dati che garantisce un miglioramento delle prestazioni, minore consumo di risorse e riduzione dei costi totali di archiviazione per i sistemi di produzione.

Buon 2026 a tutti.